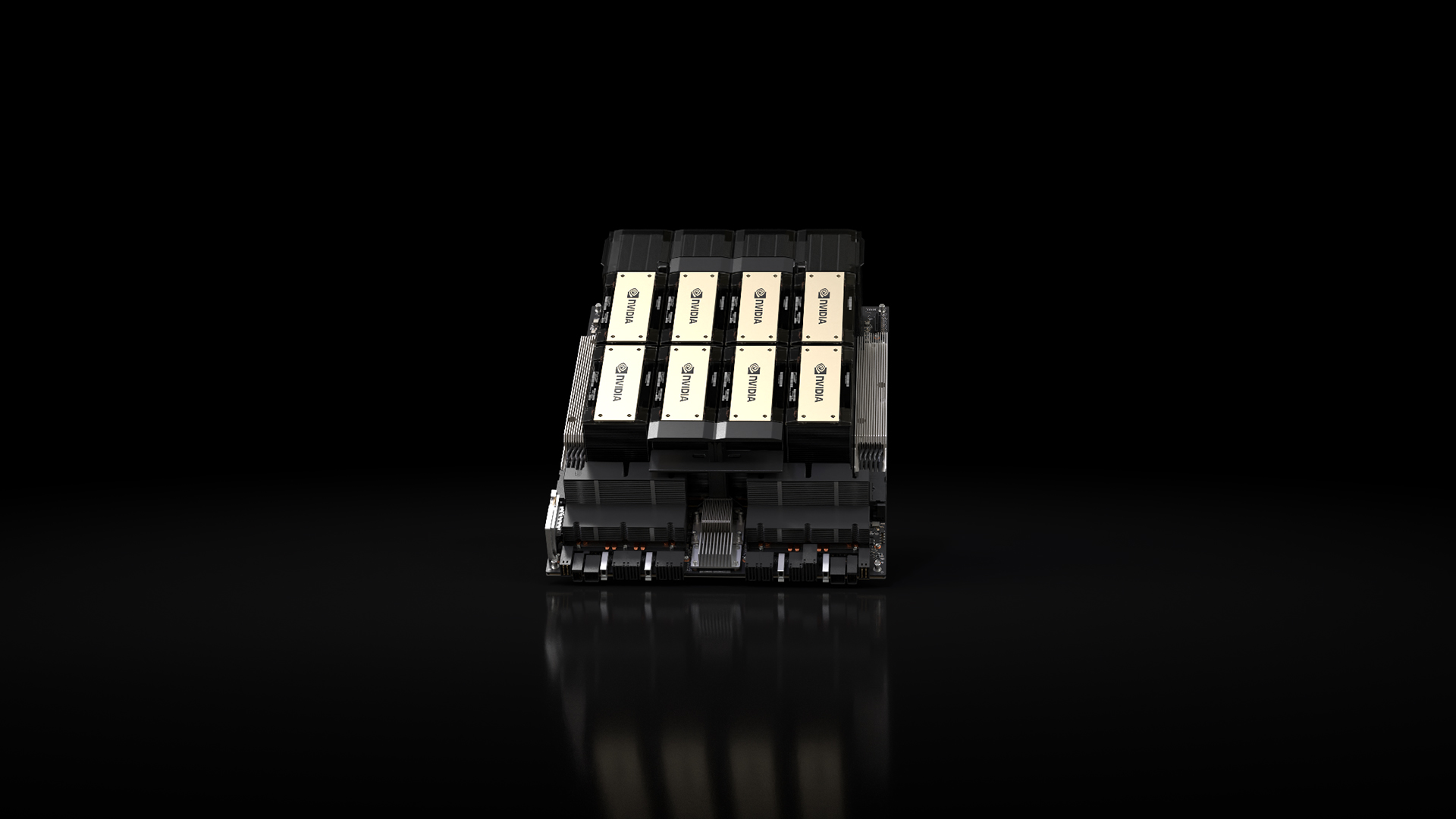

كشفت شركة “إنفيديا”NVIDIA عن إطلاق أحدث وحدة معالجة رسوميات لمركز البيانات، HGX H200، خلال كلمتها الرئيسية في مؤتمر الحوسبة الفائقة السنوي SC23. تم بناء H200 على بنية Hopper المتقدمة للشركة، ويقدم تحسينات كبيرة في الأداء من شأنها أن تقود الموجة التالية من الذكاء الاصطناعي التوليدي والحوسبة عالية الأداء.

تتميز NVIDIA H200 هي تكاملها مع تقنية الذاكرة HBM3e. يمثل هذا أول مثيل لوحدة معالجة الرسومات التي تقدم HBM3e، والتي توفر سعة ذاكرة أسرع وأكبر. يتميز جهاز H200 بذاكرة رائعة تبلغ سعتها 141 جيجابايت بمعدل إنتاجية يبلغ 4.8 تيرابايت في الثانية. تتضاعف هذه السعة تقريبًا، ويبلغ عرض النطاق الترددي 2.4 مرة مقارنة بـ NVIDIA A100، مما يجعل H200 مكونًا رائدًا في التعامل مع أحمال عمل الذكاء الاصطناعي والحوسبة عالية الأداء المعقدة.

اقرأ المزيد:- لينوفو تستثمر مليار دولار في إنفيديا لجلب الذكاء الاصطناعي إلى منتجاتها

تشير NVIDIA أن H200 سيوفر سرعات استدلال أسرع بمقدار 2x تقريبًا على نماذج اللغات الكبيرة مقارنة بوحدة معالجة الرسوميات H100 التي تم إصدارها مؤخرًا. وتعزو الشركة هذه القفزات المستمرة في الأداء إلى التحسينات المستمرة للبرامج التي تتيحها منصة الذكاء الاصطناعي الموحدة الخاصة بها.

سلط إيان باك، نائب رئيس Hyperscale وHPC في NVIDIA، الضوء على تأثير الذاكرة المتقدمة لـ H200. صرح باك في عرض فيديو: “إن تكامل ذاكرة HBM الأسرع والأكثر شمولاً يعمل على تسريع الأداء عبر المهام التي تتطلب الكثير من الحساب بما في ذلك نماذج الذكاء الاصطناعي التوليدية وتطبيقات الحوسبة عالية الأداء مع تحسين استخدام وحدة معالجة الرسومات وكفاءتها”.